최근에 흥미롭게 읽은 기사입니다. 의사와 환자가 다이렉트 메시지로 서로 커뮤니케이션할 때, GPT와 같은 생성형 인공지능이 초안을 써준 것을 바탕으로 의사가 환자에게 메시지를 보내는 것에 대한 여러 논란과 이슈를 정리한 뉴욕타임즈 기사입니다.

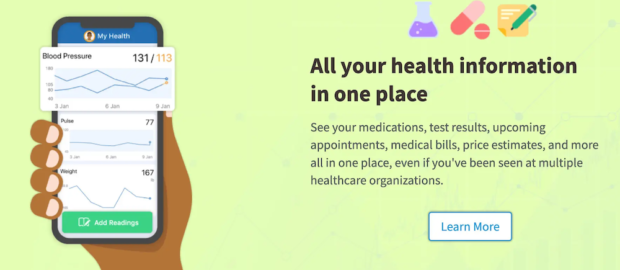

미국의 1위 EMR 회사인 Epic의 환자 포털인 MyChart에는 최근 In Basket Art라는 인공지능 툴이 추가되었는데요. 이는 GPT-4에 기반해서 의사가 환자로부터 받은 메시지에 답변할 때, 그 초안을 만들어주는 기능을 합니다. 의사가 답장을 쓸 때 빈 화면에서 시작하는 것이 아니라, GPT-4가 환자의 질문 뿐만 아니라, 과거 메시지, 진료기록까지 참고하여 미리 답변을 써주게 됩니다. 그러면 의사는 이 초안을 검토하여 환자에게 보내는 것인데요.

이런 기능이 추가된 배경이 흥미롭습니다. 코로나 판데믹을 거치면서 모든 의료 리소스가 응급 환자들에게 쏠리면서, 비응급 환자들은 우선순위가 낮아지고 비대면으로 진료하게 되면서, 환자들이 의사에게 직접 문의할 수 있는 MyChart의 메시징 기능을 더 많이 활용하게 되었다는 것입니다.

그런데 판데믹이 끝난 이후에도, 환자들의 이런 행동 양식 변화는 그대로 남아서, 여전히 의사들에게 환자들로부터 어마어마한 양의 메시지가 쏟아진다고 합니다. 의사들이 점심시간과 업무 시간 이후 저녁에도 이 메시지에 답하느라 시간을 쓰고 있고, 이것이 의사들의 주요 번아웃 원인이 되고 있다고 하는데요.

인공지능에 기반하여 의사들의 번아웃을 줄이고, 업무 효율을 높이기 위해서 미국의 많은 병원들이 이 기능을 도입하고 있다고 합니다. 적어도 150개 이상의 의료 시스템에서, 15,000의 의사 및 의료 인력들이 이 기능을 활용하고 있다고 합니다. 여기에는 UCSD, 스탠퍼드, U.W Health 와 같은 메이져 병원들도 포함됩니다.

하지만 여기에는 여러가지 논란이 있을 수 있습니다. 대표적으로 아래와 같은 것들입니다.

- 환자에게 정말 의학적으로 오류 없는, 정확한 메시지가 가는가?

일단 GPT-4 등에는 항상 할루시네이션 등의 오류 가능성이 있는데 (연구에 따르면 116개의 메시지 초안 중에 7개에 심각한 할루시네이션이 있었다고) 초안 메시지에서 의사가 검토하는 과정에서 틀린 메시지를 정말 잘 가려낼 수 있느냐 하는 것입니다. 인간에게는 소위 ‘자동 편향(automation bias)’이 있기 때문에, 연구에 따르면 인공지능이 틀린 답을 줘도 인간이 자신의 전문성에 반하는 결정도 받아들일 가능성이 높다고 합니다.

특히, 기술이 좋아질수록 의사들이 검토할 때 초안 메시지를 덜 꼼꼼하게 볼 수밖에 없는데, Mychart에 따르면 이미 1/3 정도의 메시지를 수정하지 않고 보내고 있다고 합니다.

- 번아웃을 낮추고, 시간을 아끼기기 위해서 정말 도움이 되는가?

아직은 이 근거도 명확하지 않다고 기사에는 언급되어 있습니다. 관련 초기 연구에 따르면 인지적 번아웃을 줄이는 것에는 도움이 되는 것으로 나오지만, 실질적으로 업무 시간 감소에는 유의미한 개선이 없었다고 하네요.

- 초안 메시지에 가드레일을 둬서, 임상적 조언까지는 하지 않는 것이 좋을까?

MyChart에는 instruction을 바꿔서 임상적 조언까지 초안에 허용할지 여부를 결정할 수 있는 기능이 있다고 합니다. 이런 가드레일을 만드는 것이 환자의 안전을 위해서 좋을 수도 있지만, 일단은 생성형 인공지능에서 기술적으로 이를 완벽하게 해결하는 것이 어렵다고 합니다.

더 나아가서, ‘임상적 조언’을 하지 못하게 강제하면, 메시지 초안 자체의 퀄리티가 떨어지는 문제가 있다고 하네요. 트레이드 오프가 있는 문제인데, UCSD와 스탠퍼드 등에서는 초안의 퀄리티를 높이기 위해서 이 가드레일을 없애고 ‘관리된 위험’을 감수 하기로 결정했다고 합니다.

- 인공지능이 메시지 초안을 썼다는 것을 밝히는 것이 좋은가?

이는 병원마다 다르게 생각한다고 합니다. UCSD 병원에서는 disclaimer로 이를 투명하게 밝히고 있으나, 스탠퍼드에서는 이를 밝히는 것이 득보다 실이 많다고 생각한다고 합니다. 이를 밝히면 임상적인 가치가 떨어질 수도 있고, 의사들이 면책 조항을 제대로 확인하지 않고 환자들에게 메시지를 보내는 핑계가 될 수도 있다고 이야기 합니다.

- 윤리적으로 옳은가? 환자들은 어떻게 느낄까?

환자들은 의사들과 ‘개인적으로’ 커뮤니케이션하기를 원하는 것인데, 이를 중간에 인공지능이 개입하게 되면 실망감을 느낄 수도 있다고 언급하고 있습니다. 또 어떤 환자는 별 문제가 되지 않는다고도 언급하기도.

마지막으로, 이런 방식으로 의료 분야의 인공지능이 발전하는 것이 정말 우리가 원하는 것인가. 하는 부분도 있습니다. 기술의 도움을 받는 이유가, 의사와 환자가 더 직접 잘 소통하기 위해서인데, 오히려 커뮤니케이션 과정에 직접 인공지능이 개입하게 되면 그러한 의사-환자 커뮤니케이션과 상호작용을 저해하는 결과를 낳는 것이 아닌가 하는 것입니다.

실제로 의사 중에서는 이 기능을 써보고서는 ‘내 목소리가 아닌 것 같다’, ‘7년 동안 진료한 환자인데, 이 기능을 쓰면 내가 아닌 것을 금방 알아차릴 것이다’ 라는 이야기를 하기도 했다고 하네요. (여기에 대응하기 위해서 인공지능이 각 의사의 과거 메시지에 더 많이 접근하고 학습해서, 해당 의사의 문체까지 초안에 반영하는 쪽으로 발전한다고 하기도 합니다만..)

Discover more from 최윤섭의 디지털 헬스케어

Subscribe to get the latest posts sent to your email.

![[공지] DHP Health-X 부트캠프 2025의 참여 스타트업을 모집합니다!](https://www.yoonsupchoi.com/wp-content/uploads/2025/05/banner_-140x90.png)

글 잘읽었습니다. 저는 내과 개원의사입니다. 차트프로그램을 통해 환자가 주치의사에게 직접 메세지를 보내고 의사가 이에 대한 답변을 작성하느라 AI까지 활용한다는 내용이 참 흥미롭습니다. 환자 – 의사 양방향 소통은 우리나라에도 꼭 필요하다고 생각합니다. 문제는 의사들의 활발한 참여를 이끌어 낼 “수가”겠지요. 미국은 질문에 대한 의사 답변에 환자가 건당 금액을 지불하는 수가가 책정되어 있는지 궁금합니다.

읽어주셔서 감사합니다. 수가 이야기는 따로 언급되지는 않는 것으로 보아, 아마도 아직 책정되어 있지 않을 것 같습니다.