최근 JAMA의 Viewpoint 에 흥미로운 아티클이 실렸습니다. 바로 의료 인공지능과 관련하여 가장 어려운 문제이기도 한, 책임 소재 문제입니다. 만약에 인공지능을 사용하여 진료하다가, 환자의 치료 성과가 좋지 않다면 이는 누구의 책임인가 하는 이슈입니다. 저자는 의사는 아니고, 의료법을 하시는 JD 분들이신데 2장 분량의 짧은 아티클에서, 상당히 중요한 질문을 많이 던져주고 있습니다.

기본적으로는 제가 강의에서 말씀드리거나, 제 졸저 ‘의료 인공지능’에서 언급했던 바와 일치합니다. (그래서 좀 기쁘기도..) 의료 사고 발생 시의 책임 소재(liability) 문제는 이미 ‘기존에도’ 아주 복잡한 문제입니다. 기존에도 의료 사고가 발생한 경우, 책임 소재를 가리기 위해서 법정 공방을 벌이기도 합니다. 만약 여기에 인공지능이라는 변수가 ‘추가적으로’ 개입되면 문제는 더욱 복잡해집니다. 특히, 미국에서도 관련한 판례가 아직 없기 때문에 책임 소재를 예측하기는 더욱 어려워집니다.

저자들은 현재의 법 체계 하에서, 이 문제에 간단한 가상의 사례를 세워서 체계적으로 접근하고 있습니다: “한 난소암 환자가 있는데 표준치료는 아바스틴을 3주 간격으로 15mg/kg 로 투여하는 것이다. 그런데 인공지능이 이 환자의 경우 용량을 그 다섯 배인 75mg/kg 으로 높이라고 권고했다” 는 상황을 가정합니다.

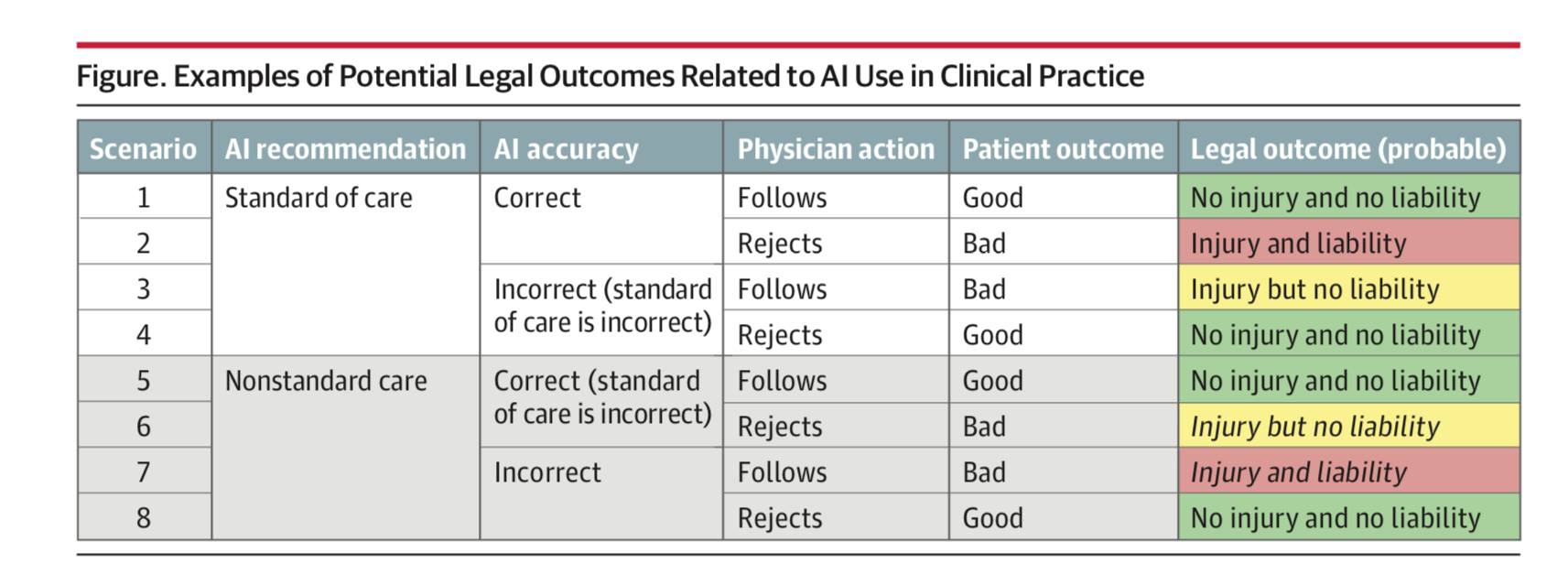

이 가설적 상황에서, 다음과 같은 상황에 대해서 yes/no 의 결정 트리(decision tree)를 타게 되면 총 8가지의 시나리오가 나오게 됩니다.

- 인공지능의 권고가 ‘표준 치료’에 해당할 경우 / 아닐 경우

- 그러한 권고가 정확할 경우 / 정확하지 않을 경우

- 의사가 이 권고를 따를 경우 / 따르지 않을 경우

- 그러한 결과, 환자의 치료 성과가 좋을 경우 / 나쁠 경우

만약 결과적으로 환자의 치료 성과가 좋다면, 어떤 경우이든 만사 오케이입니다. 의사는 아무런 법적 책임을 지지 않아도 됩니다. (시나리오 1, 4, 5, 8) 그런데 환자의 치료 결과가 좋지 않은 나머지 시나리오에서는 문제가 좀 복잡해집니다. 환자의 치료 성과가 좋지 않은 나머지 시나리오에서 “현재의 법 체계 하에서” 의사에게 가장 부담이 적은 것은, 어쨌거나 표준 치료 (standard of care)를 따르는 것입니다.

예를 들어서, 인공지능이 표준 치료를 권고해줬는데, 이것이 옳지 않다고 생각하더라도, 이 권고를 따랐을 경우, 환자의 치료 결과가 좋지 않아도 ‘Injury but no liability’ 이고 (시나리오 3), 또 한편으로 인공지능이 표준치료가 아닌 것을 권고해준 경우, 이것이 옳은 판단이라고 생각하더라도, 이를 거절하고 표준치료를 한 경우라도 (시나리오 6) 역시 ‘Injury but no liability’ 가 됩니다. (물론 현재 법체계 하에서의 법적 해석이지, 판결이 난 것은 아닙니다)

이러한 상황의 문제는 결국 현재의 법 체계 하에서 의사가 ‘표준치료를 따르는 안전한’ 선택을 하는 것에만 인센티브가 제공된다는 것입니다. 즉, 의사의 결정이 인공지능의 잠재력이나 가치를 활용할 수 없는 쪽으로 유도된다는 것입니다. 아무리 좋은 인공지능이 개발되어도, 의사들이 책임소재에 대한 부담 때문에 이를 활용하지 않게 된다면 아무런 가치가 없을 것이니까요. 이러한 상황이라면 결국 환자들은 가능한 최상의 치료를 받지 못하는 형국이 됩니다.

여기서 저자들은 사고를 좀 더 발전시켜서 흥미로운 논의들을 더 합니다. 그 중의 하나는 표준 치료(standard of care)도 결국 최신 연구 결과와 기술의 발전을 반영해서 ‘변화’한다는 것입니다. 그런데 만약에 미래에 인공지능이 표준치료의 ‘일부’가 된다면? 그래서 (최소한 일부 경우에는) 인공지능의 권고를 반영해서 의사 결정을 하라는 것 자체가 표준치료가 된다면? 하는 것입니다. 이 경우에는 시나리오, 특히 6번과 7번 (인공지능이 표준치료가 아닌 것을 권고하는 경우, 이 권고가 맞는 것으로 보이는데도 의사가 쓰지 않거나, 반대로 틀린 것 같은데도 의사가 따르는 경우) 에서의 책임소재가 변화할 수 있다고 언급합니다.

더 나아가 이러한 책임 소재의 이슈는 단순히 병원과 의사 뿐만의 문제가 아니라, 이를 둘러싼 이해관계자 전반으로 확대되는 문제입니다. 예를 들어서, 의사들이 의료 사고에 대비해서 드는 보험의 경우에, 이러한 인공지능의 권고의 준수/미준수에 따른 보험 커버가 어떻게 달라질 것이냐.. 하는 것이 대표적입니다. 여기에는 또 해당 인공지능의 설명가능성(explainability) 여부도 중요해집니다.

이를 한국의 상황에 빗대어서 이야기 하자면, 한국의 경우에는 심평의학..을 기반으로 한 보험 급여/삭감 기준도 문제가 됩니다. (사실 어쩌면 한국에서는 이 아티클에서 기본 가정으로 하는 ‘이 환자에게는 아바스틴 용량을 세 배로 높인다는 권고를 받아들일 수 있다’는 것 자체가 심평의학에 의해 성립되지 않을지도 모르겠습니다.)

현재는 심평원과 NECA에서 ‘인공지능을 활용하는 행위’ 자체에 대한 수가를 줄지 말지, 어떤 기준으로, 어떻게, 얼마나 줄지…를 논의하고 있습니다만, 이번 아티클에서의 가정과 같이, ‘인공지능을 사용한 결과, 표준 치료와 다른 치료 방법을 권고해주고, 의사가 이를 사용하는 경우’는 논의되지 않고 있습니다. 사실 지금의 한국의 지불 체계 하에서는 무조건 삭감 대상일 것 같습니다만.. 이 부분도 갈수록 기술의 발전에 따라 최선의 치료를 제공하는 것과 괴리가 커지게 될 것으로 보입니다.

그리고 마지막으로 저자들은 이 아티클 전반에서 가정으로 하는 ‘현재의 법 체계’ 자체도 앞으로 변화할 수 있다고 이야기 합니다. 기술, 사회, 의료의 발전에 따라서 법 자체도 바뀌기 때문이지요. 그래서 이 문제는 더더욱 복잡해집니다. 법이 규제하기로 한 대상도 바뀌고, 심지어는 그 기준인 법 자체도 바뀔 수 있으니까요. 흔히 ‘움직이는 과녁(moving target)’ 이라는 표현을 쓰지만, 이 경우에는 과녁 뿐만 아니라, 과녁을 맞추려는 사람 자체도 움직이는 꼴입니다.

결국 필요한 것은 원칙입니다. 또한 이러한 원칙은 근거에 기반하여 만들어져야 합니다. 이 부분이 제가 졸저에서도, 강의에서도 항상 강조하는 것이고, 저자들도 언급하고 있습니다. 좋은 의료 인공지능을 개발하는 것과는 별개로, 의사들이 현장에서 이를 ‘어떻게’ 사용할지, 그리고 이를 둘러싼 여러 이해관계 및 인프라 전반에 대한 기준이 필요합니다. 어느 환자에게, 얼마나 높은 신뢰도를 가지고 인공지능을 활용할 것이며, 그 결과에 대한 법적인 책임소재는 어떻게 되어야 하고, 또한 그에 따른 보험사 및 지불자들의 정책은 어떻게 되어야 하는지.

이 모든 것들이 의료 현장에서 인공지능의 잠재력을 충분히 활용해서 널리 활용될 수 있고, 또 이를 통해서 환자들에게도 인공지능의 가치를 최대로 전달하기 위해 선행되어야 할 전제 조건이 될 것입니다. 사실 미국에서도 이러한 논의는 아직 부족하고 한국도 마찬가지입니다. 어쩌면 대한의료인공지능학회 에서 조만간 해야 할 일 중의 하나가 이런 부분일지도 모르겠습니다.

Discover more from 최윤섭의 디지털 헬스케어

Subscribe to get the latest posts sent to your email.